lundi, 17 janvier 2011

Les théories de la communication (1)

C'est après la première guerre mondiale, dans un contexte de Guerre Froide, de renseignement et de secret que la problématique de la communication s'est imposée aux Etats-Unis, d'où elle a pris son essor.

La théorie de l'information de Shannon (modèle télégraphique)

La Théorie de Shannon est une théorie mathématique de l'information, dite aussi de la donnée. Elle est née de considérations très pratiques : des problèmes de capacités de lignes de communication (télégraphe & téléphone) et de coût de communication. En recherchant des solutions rapides, sures et rentables pour transporter l'information, des chercheurs l'ont progressivement mise au point. Dans leur jargon en fait, la communication se limitait le plus souvent au transport de l'information, ce dernier terme étant synonyme de données, c'est-à-dire d'un ensemble de signaux non signifiants, une simple chaîne de signes (lettres/points/barres) constituant le message qu'il importait de transmettre le plus rapidement, le plus efficacement et le plus économiquement possible.

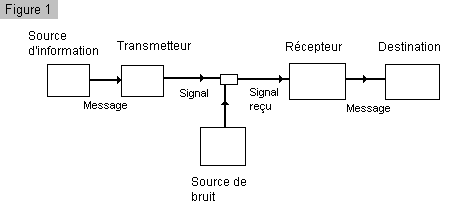

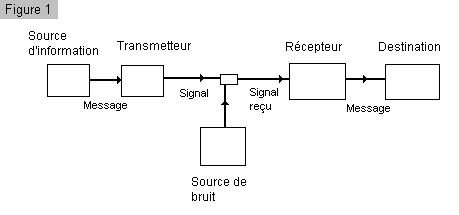

En 1949, Claude E. Shannon, un mathématicien travaillant pour la compagnie de téléphone Bell, publia la Théorie mathématique de la communication. C'est l'aboutissement de la recherche de plusieurs ingénieurs, dont Hartley, qui donna la première lettre de son nom pour désigner l'information dans une formule. La communication y est conçue comme une pure mécanique, découpable en un schéma matériel : une source d'information, qui produit un message (la parole au téléphone, par exemple) ; un émetteur, qui transforme le message en signaux (le téléphone transformant la voix en oscillations électriques) ; un canal, grâce auquel sont transportés les signaux (câble téléphonique) ; un récepteur, qui reconstruit le message à partir des signaux ; et une destination, qui est la personne (ou la chose) à laquelle le message est envoyé.

Le problème fondamental de la communication est de reproduire en un point soit exactement soit approximativement un message sélectionné à un autre point. (...)Par système de communication nous désignons un système du type indiqué par le schéma de la figure 1. Il consiste en cinq parties essentiellement.

Ces 5 parties:

- Une source d'information qui produit un message ou une série de messages à communiquer au terminal récepteur

- Un transmetteur qui traite le message de façon à produire un signal susceptible d'être transmis par le canal.

- Le canal est simplement le medium utilisé pour transmettre le message de l'émetteur au récepteur.

- Le récepteur effectue d'ordinaire l'opération inverse de celle faite par le transmetteur, en reconstruisant le message à partir du signal.

- Le destinataire est la personne (ou la chose) à qui le message est adressé

Pendant la transmission, ou à l'un des terminaux, le signal peut être perturbé par du bruit.

Le message, un ensemble de signaux codés et insensés, est donc transmis de l'émetteur au récepteur : c'est un objet, extérieur à ceux qui le produisent ou le consomment. C'est une matière, quantifiable après traitement spécifique. Ce traitement, c'est la théorie de l'information qui va le permettre en décomposant le message en unités, les bits d'information. Le message est acheminé via des canaux permettant de franchir la distance spatiale et temporelle qui sépare l'émetteur du récepteur ( canaux naturels comme les ondes de l'air ou instrumentaux comme le faisceau laser, les câbles de la télédistribution ou encore les satellites de communication). Les opérations de codage et de décodage s'effectuent sur la base d'un code dont la convention est partagée par l'emetteur et le récepteur, et qui doit être composé de signaux univoques, chaque signe ne pouvant se référer qu'à une seule chose. Ainsi conçu, le code apparait bien comme extérieur à la source de l'information. La source doit se soumettre au code. De plus, le code est préétabli : il précède ses utilisations dans les opérations de décodage. Il est des choses qu'on ne pourra donc dire, parce que des signes peuvent manquer au code. Le caractère mécaniste du modèle est ainsi manifeste.

Le message, un ensemble de signaux codés et insensés, est donc transmis de l'émetteur au récepteur : c'est un objet, extérieur à ceux qui le produisent ou le consomment. C'est une matière, quantifiable après traitement spécifique. Ce traitement, c'est la théorie de l'information qui va le permettre en décomposant le message en unités, les bits d'information. Le message est acheminé via des canaux permettant de franchir la distance spatiale et temporelle qui sépare l'émetteur du récepteur ( canaux naturels comme les ondes de l'air ou instrumentaux comme le faisceau laser, les câbles de la télédistribution ou encore les satellites de communication). Les opérations de codage et de décodage s'effectuent sur la base d'un code dont la convention est partagée par l'emetteur et le récepteur, et qui doit être composé de signaux univoques, chaque signe ne pouvant se référer qu'à une seule chose. Ainsi conçu, le code apparait bien comme extérieur à la source de l'information. La source doit se soumettre au code. De plus, le code est préétabli : il précède ses utilisations dans les opérations de décodage. Il est des choses qu'on ne pourra donc dire, parce que des signes peuvent manquer au code. Le caractère mécaniste du modèle est ainsi manifeste.

Prolongements :

De nombreuses études ont été faites dès son apparition pour appliquer la théorie de l’information de Shannon à la communication humaine. En fait, on a un peu vite superposé les notions d’information et de communication, le but des travaux étant de mesurer la capacité de l’homme comme véhicule d’information ou canal de transmission. On a pu mesurer ainsi que la limite supérieure de capacité de transmission humaine se limite à 25 bits / sec.

Mais bien au-delà, la théorie de Shannon a bientôt constitué un point de ralliement pour des disciplines aussi diverses que la physique, les mathématiques, la sociologie, la psychologie, la linguistique et la biologie moléculaire à travers les notions de code, d'émetteur, de message et de récepteur, de bruit, de redondance… En linguistique, par exemple, le mot code va s’imposer comme synonyme de langue et de système. On peut voir là une première occasion de rapprocher dans l’analyse de la communication les domaines de l’artificiel, du biologique et de l’humain.

Dès le départ, des chercheurs se sont insurgés contre une telle transposition d'un schéma mathématique dans d'autres disciplines. Toutefois, pendant plus de trois décennies, cette théorie linéaire inspirera la plupart des approches de la communication, et le schéma établi par le mathématicien Shannon – émetteur/message/récepteur – deviendra la référence obligée pour tout néophyte en sociologie des médias.

Shannon avait montré qu’au fur et à mesure qu’on apporte des données, celles-ci devenaient de plus en plus prévisibles. Il y a un inévitable passage de l’information à la redondance. Cette idée, soulignée par Shannon, que l’information ne peut que se dégrader irrémédiablement a trouvé une postérité dans les théories systémiques à venir. Un rapprochement a été fait avec la thermodynamique. En 1865, Rudolf Clausius avait montré, à propos de l’énergie, que tout ce qui est organisé et structuré est soumis à la dégradation et au retour au chaos. C’est le phénomène d’entropie. Dans une machine thermique, l’évolution d’un ordre différencié (chaud et froid séparés) donne in fine un désordre indifférencié (le tiède).

L'apport de Weaver

Warren Weaver (1896-1978) est un mathématicien, philosophe de la communication.

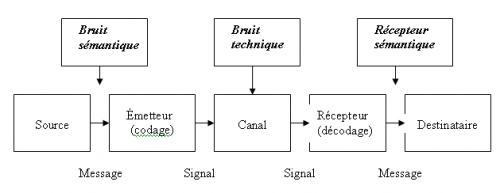

Il a « humanisé » le schéma purement technique de Shannon en y introduisant un récepteur sémantique entre le récepteur technique (qui transforme les signaux en message) et le destinataire. Ce récepteur soumet le message à un second décodage, destiné à mettre un sens sur les mots reconstitués, à accorder les caractères sémantiques des messages avec les possibilités sémantiques des destinataires. De même, Weaver suggère d'insérer entre source et émetteur un paramètre supplémentaire qualifié de bruit sémantique, rendant compte de phénomènes de perturbations ou de distorsion de signification.

La cybernétique

Le premier à avoir l'intuition du rôle structurant des nouvelles machines à communiquer est Norbert Wiener (1894-1964), mathématicien américain, le père de la cybernétique. Dans son ouvrage Cybernetics or Control and Communication in the Man and the Machine (1948), il diagnostique - alors que l'on est tout juste à l'aube de l'informatique - que la société du futur s'organisera autour de l'information.

La cybernétique : sciences du contrôle et des communications dans l’homme, l’animal et la machine.

→ Science qui se donne pour objet l’étude des systèmes vivants et non vivants ; la science des régulations au sein des organismes vivants et des machines. Notre monde est intégralement constitué de systèmes, vivants ou non-vivants, imbriqués et en interaction. Peuvent ainsi être considérés comme des "systèmes": une société, une économie, un réseau d'ordinateurs, une machine, une entreprise, une cellule, un organisme, un cerveau, un individu, un écosystème…

Un système cybernétique peut être défini comme un ensemble d'éléments en interaction, les interactions entre les éléments peuvent consister en des échanges de matière, d'énergie, ou d'information.

Ces échanges constituent une communication, à laquelle les éléments réagissent en changeant d'état ou en modifiant leur action. La communication, le signal, l'information, et la rétroaction sont des notions centrales de la cybernétique et de tous les systèmes, organismes vivants, machines, ou réseaux de machines.

L’apport de Wiener au modèle de la communication : le feedback ou processus de régulation.

L'approche cybernétique d'un système consiste en une analyse globale des éléments en présence et surtout de leurs interactions réciproques. L'action d'un élément sur un autre entraîne en retour une réponse (rétroaction ou "feedback") du second élément vers le premier. On dit alors que ces deux éléments sont reliés par une boucle de feedback (ou boucle de rétroaction). Le message de Rétroaction (ou Feedback, ou encore message de feed-back en anglais), est donc le message, verbal ou non, renvoyé par réaction par le récepteur, à l'émetteur. Lorsqu'il existe, on parle de communication bidirectionnelle. Ses enjeux sont différenciés de ceux du message dont il est issu. Le feed-back peut servir, suivant les cas, à:

- confirmer la réception du message ;

- infirmer la réception du message ;

- demander des précisions ;

- relancer la discussion ;

- terminer la discussion.

La notion de rétroaction (feed-back) a permis aux chercheurs en sciences humaines de passer d'une vision linéaire (unidirectionnelle) de la communication, à la conception d'un processus circulaire (bidirectionnelle).

On peut distinguer selon Wiener deux formes de Feed-Back :

- Le Feed-back positif, qui conduit à accentuer un phénomène, avec un effet possible de boule de neige (hausse de la tension entre les communicants. Entre humains il s'agirait d'énervement entre deux personnes).

- Le Feed-back négatif peut être considéré comme un phénomène de régulation, qui en amoindrissant la communication, tend à la maintenir stable et équilibrée. Cette régulation prends plusieurs formes notamment la reformulation ou le questionnement.

Ces deux formes du Feed-back assurent la réception du message. Le troisième cas, dans lequel le Feed-back n'est pas exprimé (néant), crée un frein à la communication: on ne sait même pas si le message a été reçu ou pas. C'est souvent le cas dans la communication de masse.

→ C’est une révolution, car la communication cesse d’être conçue comme linéaire, mais comme circulaire (boucles) : Emetteur et récepteur interagissent.

Wiener distingue 2 types de feedback :

feedback positif : il conduit à accentuer un phénomène (Réactions de B renforcent l’attitude A)

feedback négatif : régulation, amortit le phénomène (Réactions de B conduisent A à se corriger).

21:29 Publié dans théorie du signe | Tags : claude shannon, wiener, weaver, feed-back | Lien permanent | Commentaires (0)

samedi, 20 mars 2010

Claude Shannon (1916-2001)

Claude Shannon est né le 30 avril 1916 à Gaylord dans le Michigan, dont il fréquente l’université. Et où il obtient une licence de mathématiques et de physique. Il entre au M.I.T et dans sa thèse de Master, « Une analyse symbolique des circuit à relais et de commutation » il utilise l’algèbre de Boole pour concevoir les circuits de commutation. Il apporte ainsi un outil théorique aux concepteurs de circuits logiques, qui servira aussi bien pour les circuits à relais que pour les circuits intégrés. Le professeur Howard Gardner de Harward considère cette thèse comme peut - être la plus importante du siècle. Il travaille en même temps sur l’analyseur différentiel de Vannevar Bush.

Claude Shannon est né le 30 avril 1916 à Gaylord dans le Michigan, dont il fréquente l’université. Et où il obtient une licence de mathématiques et de physique. Il entre au M.I.T et dans sa thèse de Master, « Une analyse symbolique des circuit à relais et de commutation » il utilise l’algèbre de Boole pour concevoir les circuits de commutation. Il apporte ainsi un outil théorique aux concepteurs de circuits logiques, qui servira aussi bien pour les circuits à relais que pour les circuits intégrés. Le professeur Howard Gardner de Harward considère cette thèse comme peut - être la plus importante du siècle. Il travaille en même temps sur l’analyseur différentiel de Vannevar Bush.

En 1941, muni de son PHD, il entre aux laboratoires Bell qu’il quittera en 1972. Il travaille sur les problèmes théoriques d’information et de commutation et en particulier durant la guerre sur la cryptographie.

Il publie en 1949 « Théorie de la communication des systèmes secrets ».C’est dans le cadre de ses travaux à la Bell qu’il publie, également en 1949, aidé du mathématicien Waren Weaver, le texte fondateur de la théorie de l’information, son fameux « Théorie mathématique de la communication »C’est aussi en 1949 qu’il épouse Mary Elisabeth « Betty » Moore qui lui donnera 3 enfants.

En parallèle à ses activités à la Bell il est professeur au MIT à partir de 1959.

Claude Shannon est par ailleurs un esprit curieux de tout. Il fabrique une machines à jongler, une souris qui traverse les labyrinthes, une machine qui résout le cube de Rubik, une autre qui joue aux échecs, qui ne sera battue qu’en 42 coups par le champion du monde Mikhail Botvinnik en 1965 à Moscou.

Il est également passablement fantaisiste et les ingénieurs de la Bell se le rappellent chevauchant un monocycle en jonglant avec 3 balles dans les couloirs du labo.

Cela ne l’empêche pas de recevoir toutes les distinctions que son génie mérite, en particulier la Médaille Nationale de la Science des mains du président Johnson en 1966 et le Prix Kyoto pour la Science de Base.

Il était membre de nombreuses et prestigieuses sociétés savants et docteur Honoris Causa de nombreuses universités : Yale, Michigan, Princeton, Edimburgh, Princeton, Pittsburgh, Northwestern, Oxford, East Anglia, Carnegie-Mellon, Tufts, Pennsylvania.

Même après sa retraite de professeur, il continuera à travailler au MIT jusqu'à ce que la maladie d’Alzeimer le conduise au Courtyard Nursing Care Center de Medford, Mass., où il mourra le 24 février 2001.

L'importance des travaux de Shannon

La présentation par Claude Shannon dans les années 1940 de la théorie de l’information est certainement une des grandes réalisations du 20ème siècle.

La théorie de l’information a eu grande influence sur les mathématiques en particulier sur la théorie des probabilités, et les mathématiques de Shannon en elles mêmes sont une contribution importante aux mathématiques pures.

Dans son papier maintenant classique il a formulé un modèle de système de communication remarquable par sa généralité et sa facilité à être traité mathématiquement. Il a formulé les problèmes théoriques centraux et leur a donné une solution élégante.

L’idée de base est que tout message se résume à une suite de 0 et de 1. On peut en effet digitaliser tout signal sans perte d’information pourvu que la fréquence d’échantillonnage soit supérieure au double de plus haute fréquence à transmettre (Théorème de Shannon)

Shannon voit le processus de communication comme stochastique par nature. L’aspect sémantique de l’information ne joue aucun rôle dans son modèle.

L’information d’une « source », définie comme un processus stochastique doit être transmise par un « canal » défini par une loi de probabilité de transition reliant entrée et sortie de celui-ci.

Le concepteur du système peut placer un codeur entre source et canal qui peut introduire un retard fixe et fini, et un décodeur entre canal et sortie.

Sa théorie cherche à répondre à des questions telles que la rapidité et la fiabilité de la transmission, en optimisant codeur et décodeur.

Shannon donne des réponses élégantes à ces questions. Sa solution comprend deux parties :

La 1ère donne des limites fondamentales, par exemple que pour une source et un canal donnés il est impossible d’obtenir une fidélité et une fiabilité supérieures à des valeurs données.

La 2ème montre qu’on peut atteindre la limite théorique moyennant un codeur pouvant apporter un retard important. Pour ce faire ce codeur peut utiliser un code complexe, pas nécessairement implémentable en pratique.

Un de ses apports les plus importants a été de montrer qu’on pouvait étudier source et canal indépendamment, en supposant qu’ils étaient connectés par une interface digitale. On définira le codeur pour optimiser la performance source/canal et le décodeur pour optimiser le canal comme transmetteur digital. La résolution des problèmes de la source et du canal résout de facto celui de la liaison complète.

La complexification des systèmes informatiques et de communication rend de plus en plus nécessaires les apports théoriques de Shannon qui débordent même la pure technique pour apporter des outils déterminants dans des sciences humaines telles que la linguistique.

"Le problème fondamental de la communication est de reproduire en un point soit exactement soit approximativement un message sélectionné à un autre point". (...)

"Par système de communication nous désignons un système du type indiqué par le schéma de la figure 1. Il consiste en cinq parties essentiellement".

Ces 5 parties:

"Une source d'information qui produit un message ou une série de messages à communiquer au terminal récepteur"

"Un transmetteur qui traite le message de façon à produire un signal susceptible d'être transmis par le canal".

"Le canal est simplement le medium utilisé pour transmettre le message de l'émetteur au récepteur".

"Le récepteur effectue d'ordinaire l'opération inverse de celle faite par le transmetteur, en reconstruisant le message à partir du signal".

"Le destinataire est la personne (ou la chose) à qui le message est adressé".

"Pendant la transmission, ou à l'un des terminaux, le signal peut être perturbé par du bruit".

13:07 Publié dans Les hommes de la communication | Tags : claude shannon | Lien permanent | Commentaires (0)