samedi, 20 mars 2010

Claude Shannon (1916-2001)

Claude Shannon est né le 30 avril 1916 à Gaylord dans le Michigan, dont il fréquente l’université. Et où il obtient une licence de mathématiques et de physique. Il entre au M.I.T et dans sa thèse de Master, « Une analyse symbolique des circuit à relais et de commutation » il utilise l’algèbre de Boole pour concevoir les circuits de commutation. Il apporte ainsi un outil théorique aux concepteurs de circuits logiques, qui servira aussi bien pour les circuits à relais que pour les circuits intégrés. Le professeur Howard Gardner de Harward considère cette thèse comme peut - être la plus importante du siècle. Il travaille en même temps sur l’analyseur différentiel de Vannevar Bush.

Claude Shannon est né le 30 avril 1916 à Gaylord dans le Michigan, dont il fréquente l’université. Et où il obtient une licence de mathématiques et de physique. Il entre au M.I.T et dans sa thèse de Master, « Une analyse symbolique des circuit à relais et de commutation » il utilise l’algèbre de Boole pour concevoir les circuits de commutation. Il apporte ainsi un outil théorique aux concepteurs de circuits logiques, qui servira aussi bien pour les circuits à relais que pour les circuits intégrés. Le professeur Howard Gardner de Harward considère cette thèse comme peut - être la plus importante du siècle. Il travaille en même temps sur l’analyseur différentiel de Vannevar Bush.

En 1941, muni de son PHD, il entre aux laboratoires Bell qu’il quittera en 1972. Il travaille sur les problèmes théoriques d’information et de commutation et en particulier durant la guerre sur la cryptographie.

Il publie en 1949 « Théorie de la communication des systèmes secrets ».C’est dans le cadre de ses travaux à la Bell qu’il publie, également en 1949, aidé du mathématicien Waren Weaver, le texte fondateur de la théorie de l’information, son fameux « Théorie mathématique de la communication »C’est aussi en 1949 qu’il épouse Mary Elisabeth « Betty » Moore qui lui donnera 3 enfants.

En parallèle à ses activités à la Bell il est professeur au MIT à partir de 1959.

Claude Shannon est par ailleurs un esprit curieux de tout. Il fabrique une machines à jongler, une souris qui traverse les labyrinthes, une machine qui résout le cube de Rubik, une autre qui joue aux échecs, qui ne sera battue qu’en 42 coups par le champion du monde Mikhail Botvinnik en 1965 à Moscou.

Il est également passablement fantaisiste et les ingénieurs de la Bell se le rappellent chevauchant un monocycle en jonglant avec 3 balles dans les couloirs du labo.

Cela ne l’empêche pas de recevoir toutes les distinctions que son génie mérite, en particulier la Médaille Nationale de la Science des mains du président Johnson en 1966 et le Prix Kyoto pour la Science de Base.

Il était membre de nombreuses et prestigieuses sociétés savants et docteur Honoris Causa de nombreuses universités : Yale, Michigan, Princeton, Edimburgh, Princeton, Pittsburgh, Northwestern, Oxford, East Anglia, Carnegie-Mellon, Tufts, Pennsylvania.

Même après sa retraite de professeur, il continuera à travailler au MIT jusqu'à ce que la maladie d’Alzeimer le conduise au Courtyard Nursing Care Center de Medford, Mass., où il mourra le 24 février 2001.

L'importance des travaux de Shannon

La présentation par Claude Shannon dans les années 1940 de la théorie de l’information est certainement une des grandes réalisations du 20ème siècle.

La théorie de l’information a eu grande influence sur les mathématiques en particulier sur la théorie des probabilités, et les mathématiques de Shannon en elles mêmes sont une contribution importante aux mathématiques pures.

Dans son papier maintenant classique il a formulé un modèle de système de communication remarquable par sa généralité et sa facilité à être traité mathématiquement. Il a formulé les problèmes théoriques centraux et leur a donné une solution élégante.

L’idée de base est que tout message se résume à une suite de 0 et de 1. On peut en effet digitaliser tout signal sans perte d’information pourvu que la fréquence d’échantillonnage soit supérieure au double de plus haute fréquence à transmettre (Théorème de Shannon)

Shannon voit le processus de communication comme stochastique par nature. L’aspect sémantique de l’information ne joue aucun rôle dans son modèle.

L’information d’une « source », définie comme un processus stochastique doit être transmise par un « canal » défini par une loi de probabilité de transition reliant entrée et sortie de celui-ci.

Le concepteur du système peut placer un codeur entre source et canal qui peut introduire un retard fixe et fini, et un décodeur entre canal et sortie.

Sa théorie cherche à répondre à des questions telles que la rapidité et la fiabilité de la transmission, en optimisant codeur et décodeur.

Shannon donne des réponses élégantes à ces questions. Sa solution comprend deux parties :

La 1ère donne des limites fondamentales, par exemple que pour une source et un canal donnés il est impossible d’obtenir une fidélité et une fiabilité supérieures à des valeurs données.

La 2ème montre qu’on peut atteindre la limite théorique moyennant un codeur pouvant apporter un retard important. Pour ce faire ce codeur peut utiliser un code complexe, pas nécessairement implémentable en pratique.

Un de ses apports les plus importants a été de montrer qu’on pouvait étudier source et canal indépendamment, en supposant qu’ils étaient connectés par une interface digitale. On définira le codeur pour optimiser la performance source/canal et le décodeur pour optimiser le canal comme transmetteur digital. La résolution des problèmes de la source et du canal résout de facto celui de la liaison complète.

La complexification des systèmes informatiques et de communication rend de plus en plus nécessaires les apports théoriques de Shannon qui débordent même la pure technique pour apporter des outils déterminants dans des sciences humaines telles que la linguistique.

"Le problème fondamental de la communication est de reproduire en un point soit exactement soit approximativement un message sélectionné à un autre point". (...)

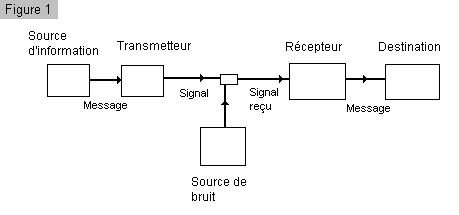

"Par système de communication nous désignons un système du type indiqué par le schéma de la figure 1. Il consiste en cinq parties essentiellement".

Ces 5 parties:

"Une source d'information qui produit un message ou une série de messages à communiquer au terminal récepteur"

"Un transmetteur qui traite le message de façon à produire un signal susceptible d'être transmis par le canal".

"Le canal est simplement le medium utilisé pour transmettre le message de l'émetteur au récepteur".

"Le récepteur effectue d'ordinaire l'opération inverse de celle faite par le transmetteur, en reconstruisant le message à partir du signal".

"Le destinataire est la personne (ou la chose) à qui le message est adressé".

"Pendant la transmission, ou à l'un des terminaux, le signal peut être perturbé par du bruit".

13:07 Publié dans Les hommes de la communication | Tags : claude shannon | Lien permanent | Commentaires (0)

Les commentaires sont fermés.